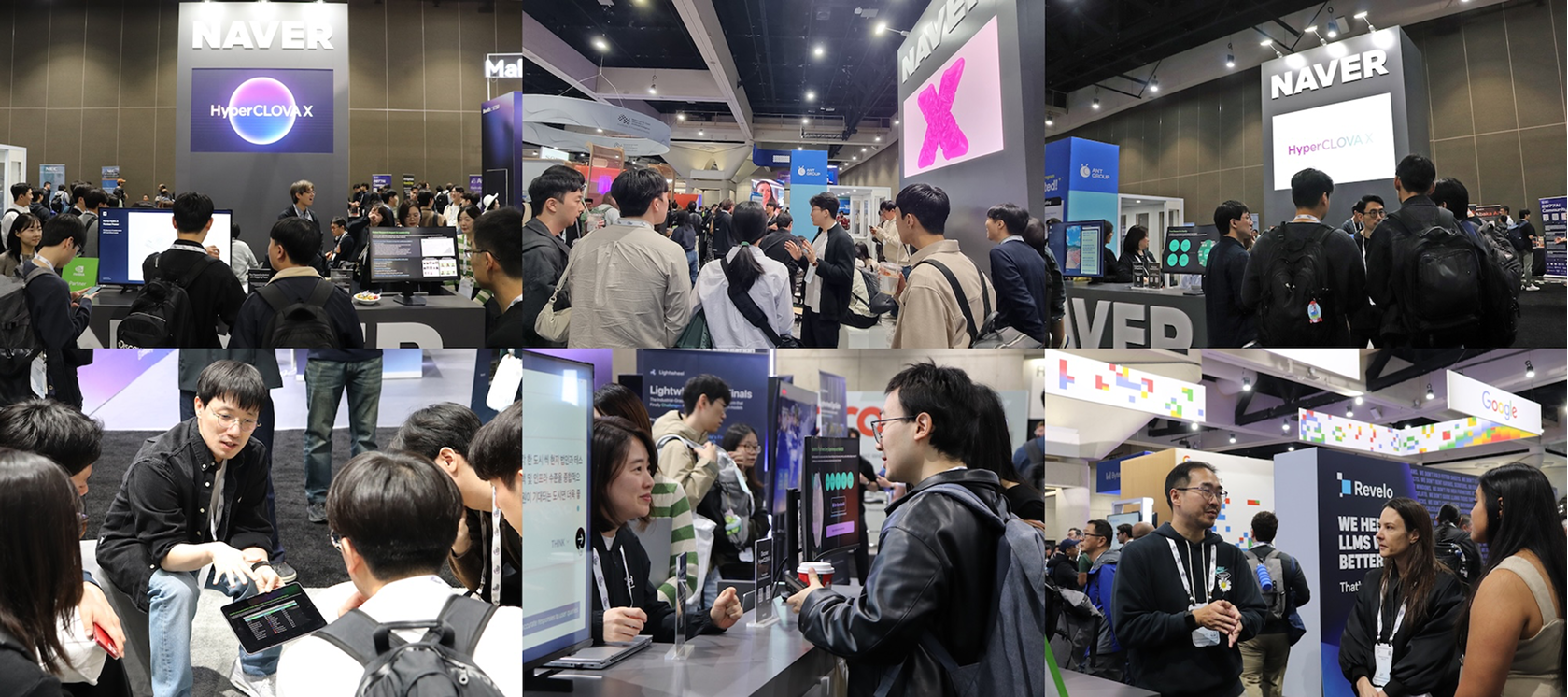

12월 초, 미국 샌디에이고에서 세계 최대 규모의 AI·머신러닝 학회 NeurIPS 2025가 열렸습니다. 올해도 전 세계 연구자·대학·기업이 한자리에 모여 AI의 미래를 논의했는데요. 그 중심에 팀네이버도 함께했습니다.

네이버는 부스 운영과 함께 9편의 연구를 발표하며, 다양한 기술 데모와 네트워킹 프로그램을 선보였습니다. 현장에서 확인한 글로벌 기술 트렌드와 우리의 연구가 가진 의미, 그리고 그 속에서 느낀 가능성을 공유합니다.

샌디에이고에서 만난 AI의 현재

29,000명이 넘는 역대 최대 규모의 참가자가 몰린 올해 NeurIPS는 개막 첫날부터 열기가 뜨거웠습니다. 최신 LLM부터 로보틱스, 멀티모달 모델까지. 각 부스마다 새로운 연구와 실험 결과가 쏟아졌고, 토크 세션과 포스터 발표장 역시 활발한 토론이 쉼 없이 이어졌습니다.

From Research to Reality

이런 분위기 속에서 팀네이버 부스 역시 많은 주목을 받았습니다. 효율적인 초거대 모델 운용, 생성형 AI의 제어·안전성, 실세계 AI 적용을 향한 우리의 연구 방향은 글로벌 연구자들에게 뚜렷한 인상을 남겼습니다.

방문객들은 데모를 직접 체험하며 논문 속 기술을 함께 토론했고, 이러한 연구가 네이버의 다양한 서비스와 인더스트리 솔루션으로 이어지는 과정에도 깊이 공감하는 반응을 보였습니다. 리크루팅 상담 역시 활발하게 진행되며, 다양한 인재들과 의미 있는 대화가 자연스럽게 이어졌습니다.

특히 여러 방문자들이 “기초 연구와 산업 기술을 동시에 깊이 있게 가져가는 전략이 돋보인다”고 평가했는데요. 네이버가 지향하는 AI 연구의 방향성과 진정성을 다시 한번 확인할 수 있는 순간이었습니다.

2025 팀네이버 AI 연구 테마: Efficiency, Control, and Real-World AI

현장에서 가장 많이 들은 질문은 하나였습니다.

“네이버는 어떤 AI를 만들고 싶은가?” 질문에 대한 답은 우리의 연구 자체에 담겨 있었습니다.

효율성(Efficiency), 제어·안전(Control), 실세계 적용(Real-World AI) 세 가지 축을 중심으로, 그 답을 선명하게 보여주는 9편의 NeurIPS 2025 채택 논문을 소개합니다.

Part 1. 더 작고 빠르게: Efficient LLM & Infrastructure

KVzip: 중요한 맥락만 남겨 효율을 높이는 KV 캐시 압축

대화를 오래 이어갈수록 모델은 앞서 했던 말들을 모두 기억해야 합니다. 그래서 기억들이 늘어나면 점점 느려지고 비용도 올라가죠.

KVzip은 이런 상황을 마치 책상 위를 정리하듯 새롭게 바라본 기술입니다. 필요한 정보만 쏙쏙 골라 간단하게 압축해 남겨두는 방식으로, 모델은 중요한 맥락은 그대로 유지하면서 훨씬 가볍게 움직입니다. 덕분에 메모리는 최대 4배 절약되고, 속도는 두 배 가까이 빨라졌죠. 사용자 입장에서는 더 빠르고 더 자연스러운 대화가 가능해지는 셈입니다.

* 논문정보: KVzip: Query-Agnostic KV Cache Compression with Context Reconstruction

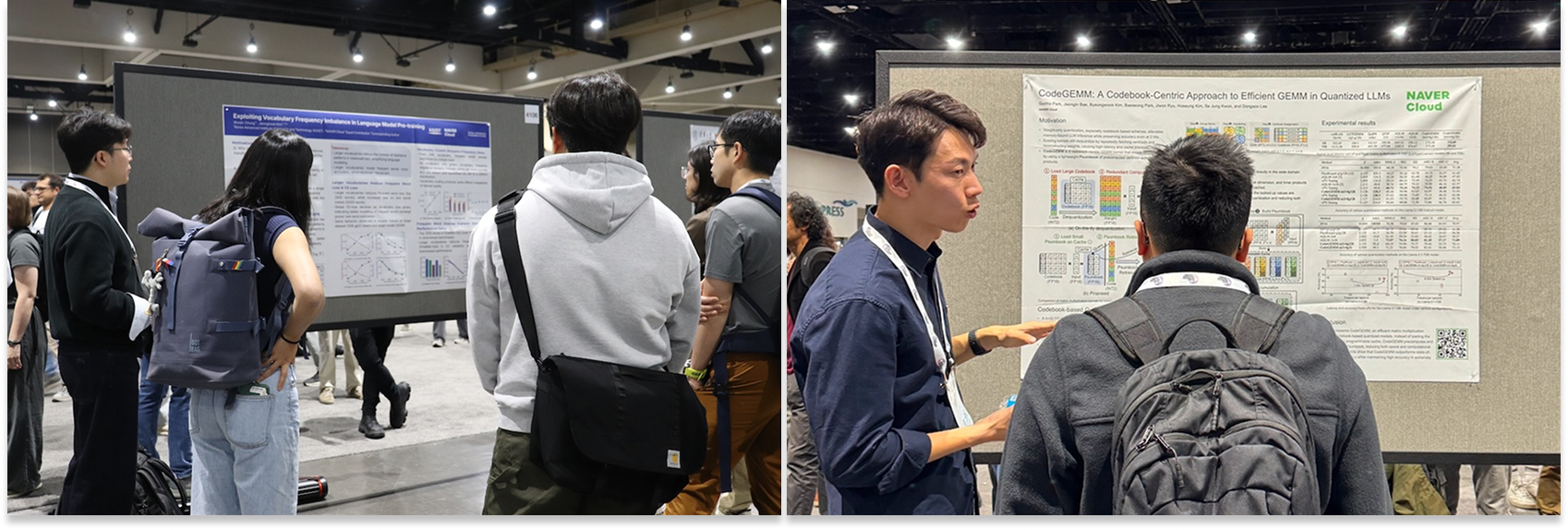

CodeGEMM: 복원 없이 빠르게 계산하는 초저비트 LLM 커널

양자화된 모델은 숫자를 간단하게 표현해서 가벼워지는 대신, 다시 원래 값으로 복원해야 하는 번거로운 과정이 뒤따릅니다. 하지만, CodeGEMM은 이 복원 과정을 통째로 건너뜁니다. 필요한 계산을 미리 만들어두고, 추론 중에는 그 조각들을 빠르게 가져와 조합하는 방식이죠.

이 아이디어를 통해 모델은 매번 무거운 계산을 반복하지 않아도 되고, 70B 같은 초거대 모델도 최대 8.93배 빨리 동작할 수 있습니다. 즉, 같은 AI를 더 적은 전력으로 훨씬 빠르게 서비스할 수 있게 만들어주는 핵심 기술입니다.

* 논문정보: CodeGEMM: A Codebook-Centric Approach to Efficient GEMM in Quantized LLMs

Vocabulary Frequency: 어휘 분포를 활용한 언어 모델 효율화 분석

언어 모델은 문장을 토큰이라는 작은 조각으로 나누어 이해합니다. 최근에는 어휘 수가 많은 토크나이저가 더 좋은 성능을 보인다는 사실만 알려져 있었죠. 그 이유는 무엇일까요? 연구팀은 간단한 관찰에서 해답을 찾았습니다.

“자주 쓰는 단어를 한 번에 인식할 수 있다면, 모델은 훨씬 적은 규칙만 기억해도 되지 않을까?”

즉, 어휘가 많을수록 AI는 ‘자주 쓰는 단어’를 더 효율적으로 처리하게 되고, 언어 속 규칙을 훨씬 빠르게 배웁니다. 해당 연구는 이를 이론적 근거와 실험으로 최초로 명확히 증명한 것으로, 앞으로 토크나이저 설계 방향에 중요한 기준이 될 통찰을 제공합니다.

* 논문정보: Exploiting Vocabulary Frequency Imbalance in Language Model Pre-training

Frequency-Aware Token Reduction: 핵심 정보만 남기는 ViT 토큰 축소

이미지를 처리하는 Vision Transformer(ViT)는 성능은 뛰어나지만, 사진 속 모든 조각을 다 처리하려 하다 보니 계산 비용이 크게 늘어나는 한계가 있습니다.

이 연구는 사람의 시선처럼 “자세히 볼 곳과 대충 봐도 되는 곳”을 구분하는 방식을 도입했습니다. 이미지에서 변화가 크거나 중요한 부분은 그대로 두고, 큰 흐름만 필요한 영역은 하나의 요약 토큰으로 정리하는 방식이죠. 그 결과, 모델은 계산을 훨씬 덜 하면서도 성능은 유지하거나 오히려 향상되었습니다. 즉, 적은 비용으로 더 똑똑하게 보는 비전 모델을 만드는 실용적 해결책을 제시합니다.

* 논문정보: Frequency-Aware Token Reduction for Efficient Vision Transformer

Part 2. 더 원하는 대로, 더 안전하게: Controllability & Safety

C-SEO Bench: 대화형 검색 환경에서의 SEO 효과 검증

대화형 검색이 본격적으로 확산되면서 많은 기업이 “AI에게 우리 콘텐츠가 잘 보이게 하는 법(C-SEO)”에 관심을 갖기 시작했습니다. 하지만 지금까지는 이러한 전략이 실제로 효과가 있는지 객관적으로 평가할 수단이 부족했습니다.

이번 연구에서는 다양한 task와 domain에서 C-SEO 기법을 검증할 수 있는 C-SEO Bench를 새롭게 제안했습니다. 실험 결과, 최신 C-SEO 방법의 상당수가 기대만큼 작동하지 않았고, 오히려 전통적인 SEO 방식보다 성능이 떨어지는 경우도 확인되었죠.

연구팀은 후속 연구를 위해 데이터셋과 코드, 벤치마크를 모두 오픈소스로 공개했으며, 보다 자세한 내용은 논문에서 확인하실 수 있습니다.

* 논문정보: C-SEO Bench: Does Conversational SEO Work?

DATE: 생성 과정에 적응하는 동적 텍스트 임베딩

기존 이미지 생성 모델은 텍스트 설명을 한 번만 반영하기 때문에, 생성 과정에서 사용자의 의도가 조금만 바뀌어도 이를 세밀하게 따라가기 어려웠습니다.

DATE(Diffusion Adaptive Text Embedding)는 이미지를 만들어가는 매 순간 텍스트 의미를 다시 읽고 조정하는 방식으로 이 한계를 해결합니다. 생성 과정에서 얻은 중간 변형 데이터를 활용해 “현재 이미지가 텍스트와 잘 맞는가?”를 확인하고, 최적화 규칙에 따라 텍스트 임베딩을 단계별로 다듬어 나가는 구조입니다.

덕분에 복잡한 장면이나 여러 대상이 등장하는 이미지, 혹은 텍스트 기반 수정 작업에서도 사용자의 의도를 훨씬 자연스럽고 정확하게 반영할 수 있습니다. 특히 추가 학습 없이 이러한 적응 능력을 확보한다는 점이 큰 장점이죠.

* 논문정보: Diffusion Adaptive Text Embedding for Text-to-Image Diffusion Models

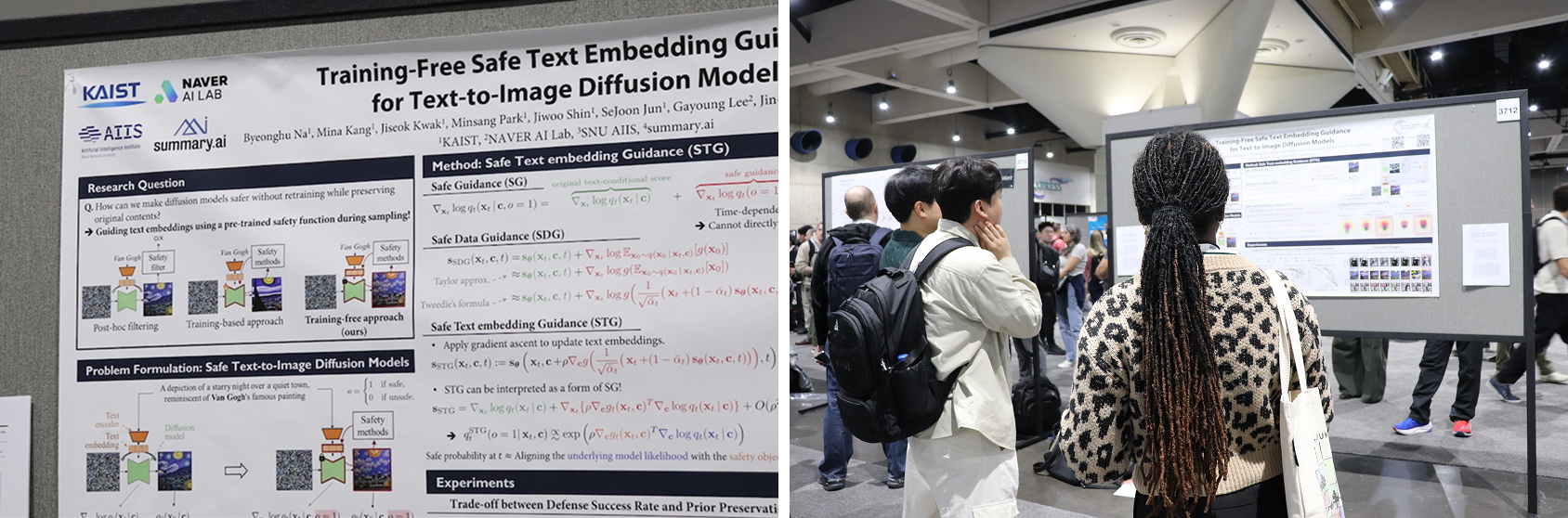

Training-Free Safe Guidance: 재학습 없이 안전성을 높이는 샘플링 가이드

최근 이미지 생성 모델의 성능이 크게 높아지면서, 의도치 않은 유해 콘텐츠가 생성될 위험 역시 함께 커졌습니다. 기존에는 안전성을 높이기 위해 모델을 재학습시키는 방법이 주로 쓰였지만, 비용과 시간이 많이 들고 실환경 적용도 쉽지 않았습니다.

Safe Text Embedding Guidance(STG)는 이러한 문제를 추가 학습 없이 해결하는 새로운 접근입니다. 생성 과정에서 예상되는 최종 디노이즈 이미지를 바탕으로 위험 신호를 평가하고, 그에 따라 텍스트 임베딩을 조정해 모델이 더 안전한 방향으로 이미지를 그리도록 유도합니다.

이 방식은 모델의 분포가 자연스럽게 안전성 제약과 정렬(alignment)되도록 하면서도, 원래 프롬프트의 의미는 그대로 유지합니다. 실험에서는 노출, 폭력, 그림체 모방 등 다양한 위험 요소를 줄이면서 기존 방식보다 안정적으로 안전한 이미지를 생성하는 것이 확인되었습니다. 무엇보다 별도의 재학습 없이 바로 적용할 수 있다는 점은 실제 서비스 환경에서 유효하게 적용될 장점입니다.

* 논문정보: Training-Free Safe Text Embedding Guidance for Text-to-Image Diffusion Models

Part 3. 실세계로 확장되는 AI: Physical AI

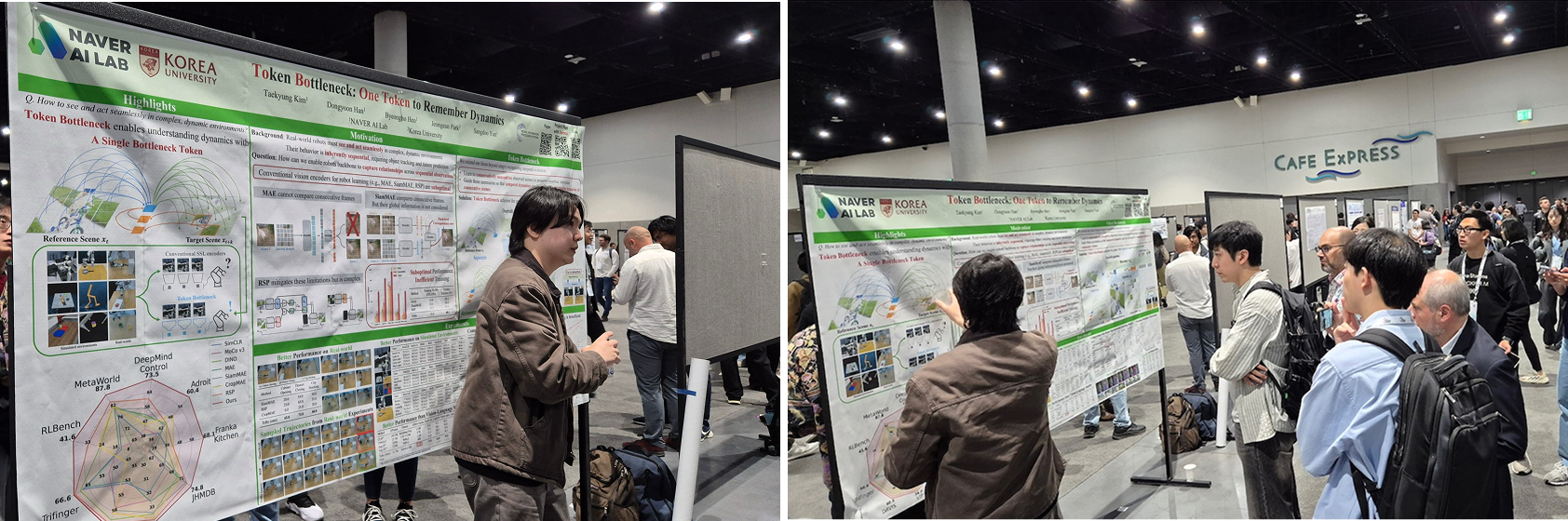

ToBo: 한 개의 토큰으로 장면 변화를 요약하는 동적 표현 학습

비디오 속 장면이나 로봇의 움직임은 시간에 따라 계속 변하지만, 대부분의 모델은 이를 프레임 단위로 모두 기억하려 하기 때문에 비효율이 생깁니다. ToBo(Token Bottleneck)는 이 문제를 전혀 다른 방식으로 풀어냅니다.

장면의 핵심 정보를 단 하나의 ‘병목 토큰’으로 압축(Squeeze)한 뒤, 이 토큰과 다음 장면의 일부 패치만을 단서로 전체 장면을 예측(Expansion)하도록 학습시키는 구조입니다. 이 과정에서 모델은 자연스럽게 시간적 흐름(temporal dynamics)을 이해하게 되며, 라벨 없이도 학습 가능한 자기지도 방식이라는 점도 특징입니다.

실험에서는 비디오 라벨 전파, 시뮬레이션·실제 로봇 조작 등 다양한 작업에서 기존 방법보다 안정적이고 일관된 성능 향상을 보였습니다. 적은 정보로도 움직임을 깊이 있게 이해하는 실용적인 접근입니다.

* 논문정보: Token Bottleneck: One Token to Remember Dynamics

Kinaema: 움직임 속에서 기억과 위치를 추적하는 순환 모델

로봇이 계속 움직이는 환경에서는 “지금 어디에 있는지”와 “방금 어떤 경로를 지나왔는지”를 스스로 기억하는 능력이 중요합니다.

Kinaema는 이런 문제를 해결하기 위해, 시간이 흐르면서도 안정적으로 유지되는 ‘메모리+자세(pose)’ 순환 구조를 갖춘 모델을 제안합니다. 장면이 바뀌어도 필요한 정보를 누적해 저장하고, 이를 바탕으로 다음 움직임을 판단하기 때문에 로봇은 적은 계산으로도 더 정확한 내비게이션을 수행할 수 있습니다.

실험에서는 시뮬레이션뿐 아니라 실제 로봇 환경에서도 안정적으로 동작하며 “변화하는 공간에서도 길을 잃지 않는 모델”이라는 평가를 받았습니다.

* 논문정보: Kinaema: a recurrent sequence model for memory and pose in motion

다시 한국에서, 다음 연구를 준비하며

NeurIPS 2025는 단순한 전시를 넘어, ‘네이버가 어떤 방향으로 AI를 만들어가고 있는지’를 세계 앞에서 다시 확인할 수 있었던 시간이었습니다.

효율적인 초거대 모델 기술, 안전하고 정교하게 제어되는 생성형 AI, 그리고 물리 세계로 확장되는 실세계 AI에 이르기까지. 네이버의 연구는 다양한 세션과 데모를 통해 그 실용성과 가능성을 명확히 보여주었습니다. 동시에 글로벌 연구자들과의 활발한 토론은 새로운 아이디어와 질문을 던져주었고, 우리의 기술 철학을 더욱 확고히 다지는 계기가 되었죠.

샌디에이고에서 돌아온 지금, 우리는 다시 연구 테이블 앞에 앉아 이번 경험을 다음 단계의 혁신으로 이어가고자 합니다. 앞으로도 더 의미 있고, 더 실용적이며, 더 안전한 AI를 향해 나아갈 팀네이버의 미래, 많은 응원 부탁드립니다!