‘생각하는 힘’을 갖춘 새로운 AI 모델, HyperCLOVA X SEED Think를 소개합니다.

HyperCLOVA X SEED Think는 추론(Reasoning) 능력을 탑재한 HyperCLOVA X 시리즈 최초의 오픈소스 모델로, 기존 SEED 모델보다 ‘생각하는 힘’이 대폭 향상되었습니다.

이 모델은 특히 다음과 같은 AI 에이전트의 핵심 역량을 중심으로 고도화되었습니다.

- 복잡한 문제를 작은 단위로 나누는 능력

- 상황에 맞는 도구나 함수를 선택하는 능력

- 실수를 반추하고 교정하는 능력

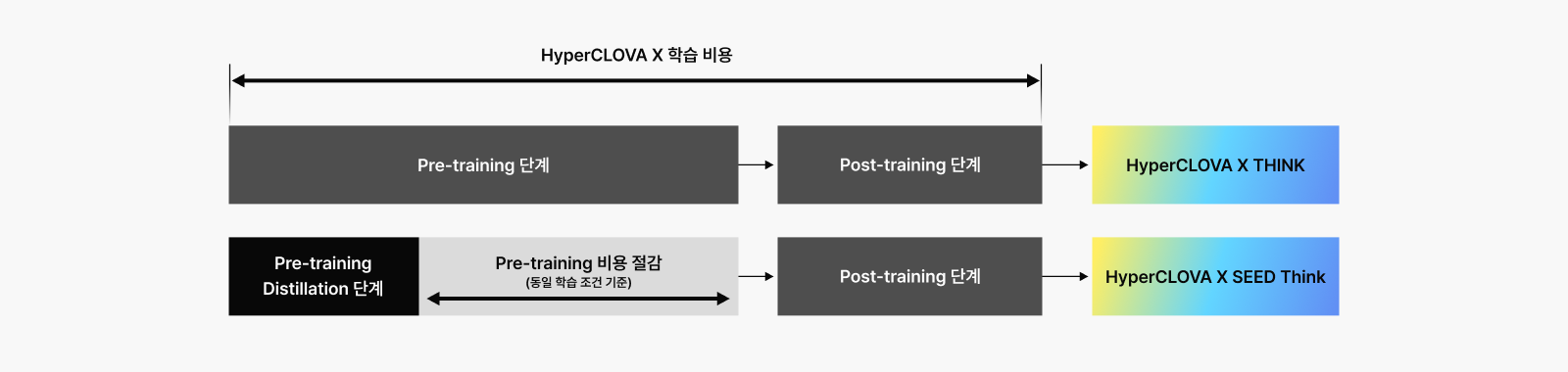

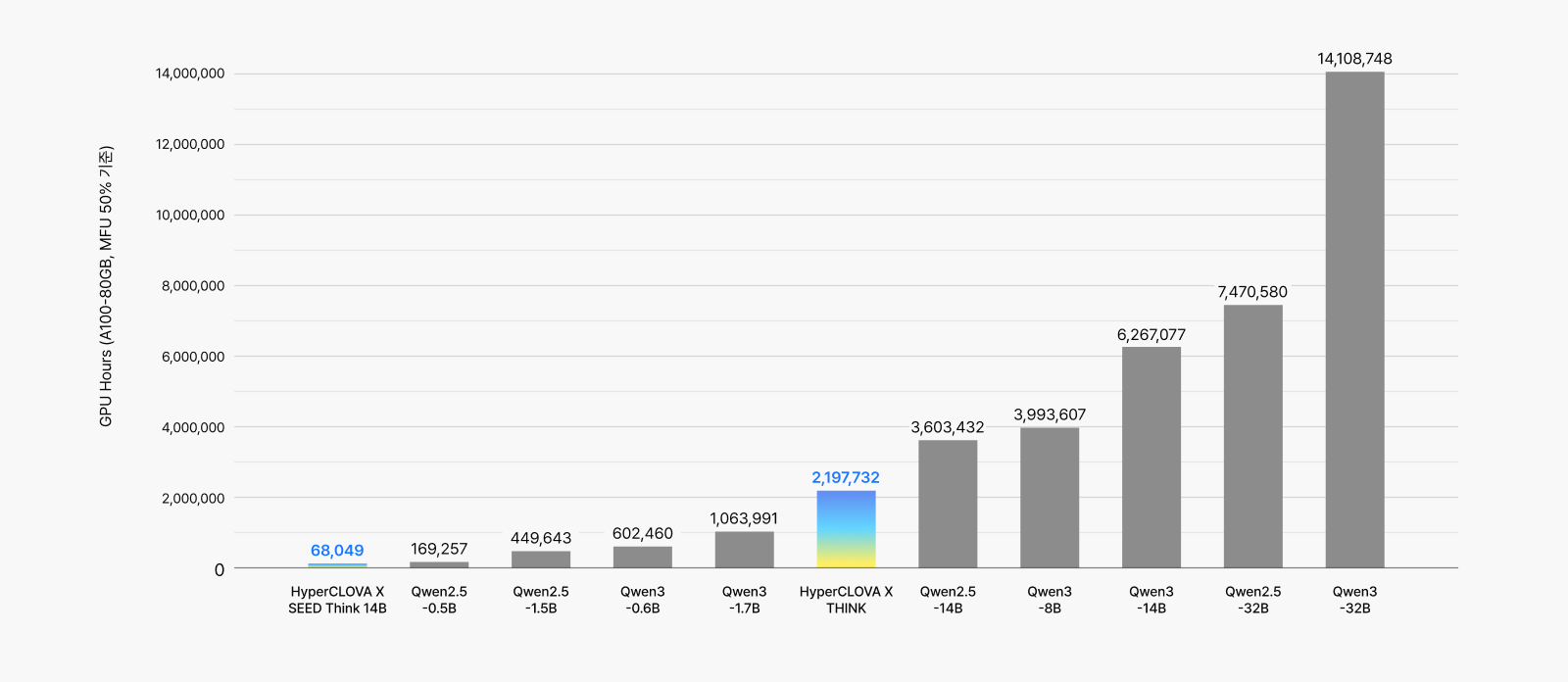

AI 생태계에 진입하는 더 많은 개발자와 연구자들에게 HyperCLOVA X SEED Think는 새로운 가능성과 혁신을 제공할 것으로 기대됩니다. 무엇보다도 주목할 점은, 글로벌 경쟁 모델 대비 1% 수준의 비용으로 학습되었음에도 우수한 성능을 안정적으로 구현했다는 점입니다.

140억 파라미터, 그 힘은 어느 정도일까?

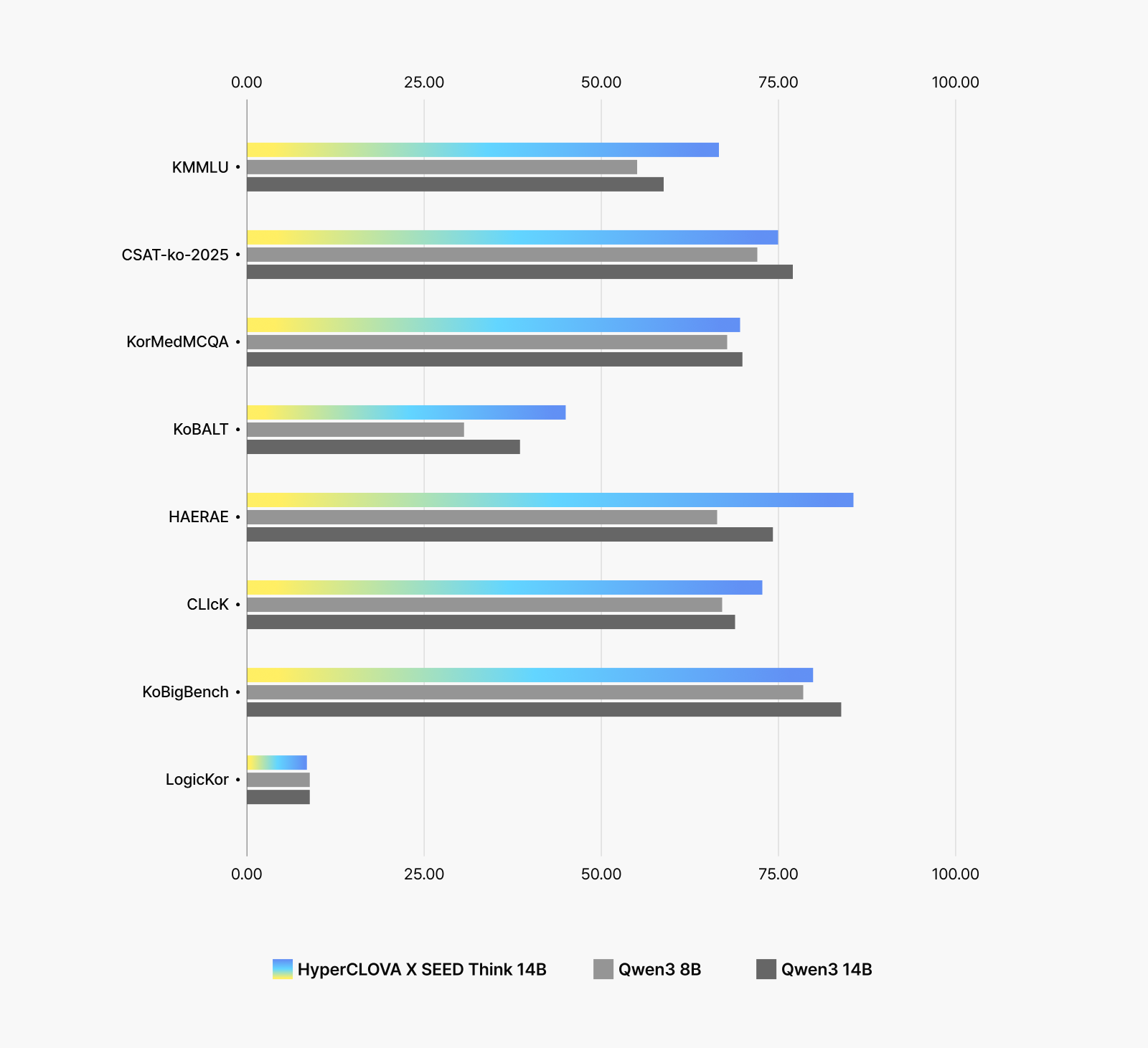

HyperCLOVA X SEED Think는 140억 개의 파라미터를 가진 중형 모델입니다. 비슷한 규모의 글로벌 모델인 QWEN3-14B와 성능을 비교해 보면, 한국어 및 한국 문화 관련 이해도와 표현력에서는 확실한 우위를 보이며, 기타 AI 에이전트의 역량과 직결되는 분야에서도 강한 경쟁력을 나타냅니다.

세부 과목을 살펴보면, HyperCLOVA X SEED Think는 한국어 및 한국 문화 관련 분야에서 동급 경쟁 모델 대비 확실한 우위를 보입니다. 특히 문법적ㆍ의미적 맥락 이해가 중요한 KoBALT와 한국사를 비롯한 상식을 평가하는 해례 벤치(HAE-RAE-Bench)에서 높은 수준의 성능을 안정적으로 입증했습니다.

단순히 크다고 강한 건 아닙니다: 작지만 똑똑한 모델의 비결은?

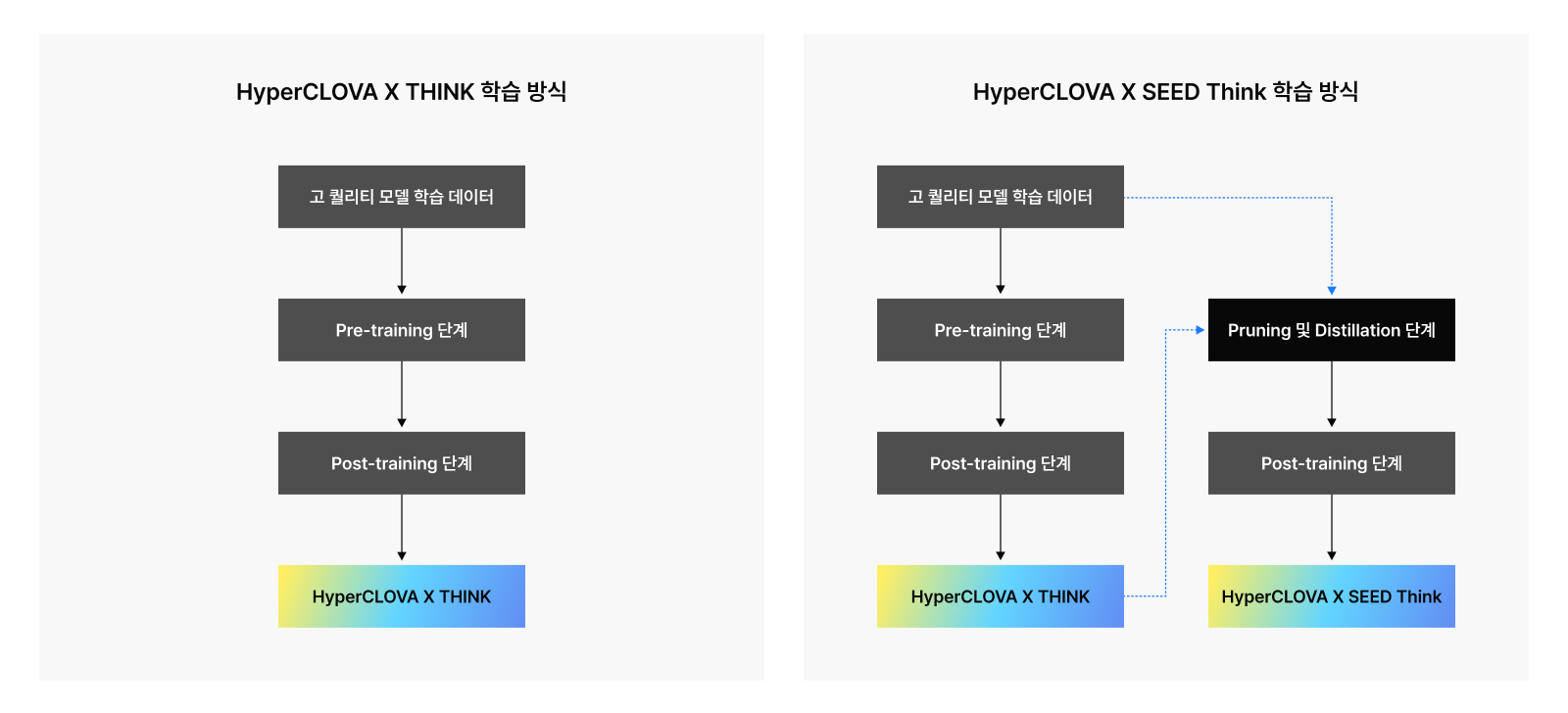

HyperCLOVA X SEED Think는 단순히 모델의 덩치를 키우는 대신에 작지만 강력한 성능을 낼 수 있는 전략을 선택했습니다. 핵심은 두 가지 기술입니다.

- 가지치기(Pruning) 및 지식 전이(Knowledge Distillation)

- 강화 학습(Reinforcement Learning) 기반 추론력 강화

이 기술들은 고성능 LLM을 ‘합리적인 비용’으로 구현하는 데 필수적인 열쇠였습니다.

Pruning & Distillation: 덜어내고, 전이시키다

가지치기(Pruning)와 지식 전이(Knowledge Distillation)는 각각 모델을 더 가볍고 효율적으로 만들기 위한 핵심 기술입니다.

- Pruning은 이미 학습된 모델에서 중요도가 낮은 파라미터를 가지치기하듯 제거하여 메모리 사용량을 줄이고 연산량까지 줄이는 방식입니다.

- Knowledge Distillation은 Pruning 과정에서 성능이 저하될 수 있는 부분을 보완하기 위한 전략으로, 큰 모델(Teacher)이 학습한 지식을 작은 모델(Student)에 전달하는 기법입니다.

즉, 덜 중요한 부분은 과감히 줄이고, 중요한 지식은 효과적으로 전이함으로써 작고 효율적인 모델에서도 높은 성능을 유지할 수 있도록 하는 것이 핵심입니다.

이러한 전략이 실제로 얼마나 효과적이었을까요? 바로 아래 그래프에서 확인할 수 있듯이 HyperCLOVA X SEED Think는 동급 모델 대비 압도적으로 낮은 비용으로 학습되었습니다.

이 두 가지 기술이 HyperCLOVA X SEED Think에서 특히 효과적일 수 있었던 배경에는 다음과 같은 기반이 있습니다.

첫째, 이미 보유하고 있는 고성능 플래그십 모델(Teacher)과 둘째, 수많은 실험과 개선을 거쳐 정교하게 완성된 학습 전략입니다. 이러한 토대 위에서, 크고 똑똑한 Teacher 모델을 모방하는 구조를 적용해 1% 수준의 비용으로도 유사 체급의 글로벌 모델과 어깨를 나란히 하는 성능을 구현할 수 있었습니다.

자세한 내용은 [관련 내용 – ‘작지만 강력하게: 고효율 LLM을 만드는 HyperCLOVA X의 경량화 기술’] 에서 확인하실 수 있습니다.

AI가 진짜로 ‘생각’할 수 있으려면?

경량화된 모델에 단순 정보만 입력한다고 추론 능력이 생기진 않습니다. HyperCLOVA X SEED Think는 AI가 ‘생각하는 방식’을 배우는 과정을 거쳤습니다. 그 핵심은 강화 학습(Reinforcement Learning) 기반의 고도화된 학습 방식입니다.

- Supervised Fine-tuning (SFT)

- Reinforcement Learning with Verifiable Reward (RLVR)

- Length Controllability (LC)

- RLHF와 RLVR 통합

우선 SFT(Supervised Fine-tuning) 단계에서는 수학이나 코딩 등 특정 도메인을 중심으로 고난도 문제의 풀이 과정을 집중적으로 모방(Imitation)하도록 하여 추론 능력의 기반을 다졌습니다.

이후 RLVR(Reinforcement Learning with Verifiable Rewards) 단계에서는 지나치게 쉽거나 어려운 문제를 학습 대상에서 제외하여 학습 효율을 높였습니다. 또한 정답 여부, 출력 포맷, 언어 등 검증할 수 있는 기준에 따라 보상을 부여함으로써 모델이 명확한 피드백을 받고 점차 성능을 개선할 수 있도록 설계했습니다.

이어진 LC(Length Controllability) 단계에서는 정해진 길이에 맞춰 응답하면 보상을 제공하여 모델이 출력 길이를 스스로 조절하는 능력을 학습할 수 있도록 했습니다.

마지막으로 인간 피드백 기반 강화 학습(RLHF)과 검증 가능한 보상을 활용한 강화 학습(RLVR)을 함께 적용하여 응답의 유용성과 논리적 추론 능력이 동시에 강화될 수 있도록 했습니다.

Pruning과 Knowledge Distillation을 통해 학습된 모델에 고도화된 추론 능력을 부여하는 일은 제법 도전적인 일입니다. 일반적으로 학습 비용이나 모델 크기를 줄이면 그에 비례해 추론 성능도 함께 떨어지는 것이 보통이기 때문이죠. 하지만 HyperCLOVA X 팀은 오랜 연구 경험과 수많은 시행착오를 바탕으로 경쟁 모델과 어깨를 나란히 할 만큼 뛰어난 추론 능력을 구현하는 데 성공했습니다.

관련 예시

HyperCLOVA X SEED Think는 AI 에이전트로서 핵심적인 세 가지 역량을 강화했습니다. 바로 복잡한 문제를 세분화해 해결하는 능력, 상황에 맞는 도구나 함수를 적절히 선택하는 능력, 그리고 자신의 실수를 되짚고 수정하는 능력입니다. 이러한 역량이 실제로 어떻게 작동하는지, 구체적인 예시들을 통해 살펴보겠습니다.

[예시 1: 수능 수학 문제풀이 요청 – 주어진 조건을 바탕으로 모델이 스스로 가설을 세우고 검증]

[예시 2: 프로그램 코드 생성 사례 – 요청 해결을 위해 스스로 세부 과제를 나누어 수행하고 결과물에 대한 논리적 전달과 최초 요청의 개선 가능 방향까지 제안]

[예시 3: 애니메이션 시리즈 제작 기획안 사례 – 다양하고 복잡한 설정과 요청을 세분화해 구체적 답변을 생성]

HyperCLOVA X SEED Think는 여기에서 자유롭게 내려받아 활용하실 수 있습니다.

이번 공개를 통해 더 많은 개발자와 연구자들이 ‘생각하는 AI’의 가능성을 함께 실험하고 확장해 나가길 기대합니다.

앞으로도 HyperCLOVA X는 작지만 강력한 모델의 진화를 통해, 모두에게 열려 있는 AI 생태계를 만들어가겠습니다.